Платная версия ChatGPT отупела, в то время как бесплатная набралась ума, выяснили учёные из Стэнфорда

Новое исследование, проведённое учёными из Стэнфордского университета и Калифорнийского университета в Беркли, выявило тревожное снижение качества ответов платной версии ChatGPT. Так, например, точность определения простых чисел у новейшей модели GPT-4, которая лежит в основе ChatGPT Plus, с марта по июнь 2023 года упала с 97,6 % до всего лишь 2,4 %. Напротив, GPT-3.5, являющаяся основной для обычного ChatGPT, точность ответов в некоторых задачах повысила.

В последние месяцы всё чаще обсуждается снижение качества ответов ChatGPT. Группа учёных из Стэнфордского университета и Калифорнийского университета в Беркли решила провести исследование с целью определить, действительно ли произошла деградация качества работы этого ИИ, и разработать метрики для количественной оценки масштабов этого негативного явления. Как выяснилось, снижение качества ChatGPT — это не байка или выдумка, а реальность.

Трое учёных — Матей Захария (Matei Zaharia), Линцзяо Чэнь (Lingjiao Chen) и Джеймс Цзоу (James Zou) — опубликовали научную работу под названием «Как меняется поведение ChatGPT с течением времени» (How is ChatGPT’s behavior changing over time). Захария, профессор компьютерных наук в Калифорнийском университете, обратил внимание на удручающий факт: точность GPT-4 в ответе на вопрос «Это простое число? Подумай шаг за шагом» снизилась с 97,6 % до 2,4 % с марта по июнь.

OpenAI открыла доступ к API языковой модели GPT-4 около двух недель назад и объявила её своей самой продвинутой и функциональной ИИ-моделью. Поэтому общественность была расстроена тем, что новое исследование обнаружило значительное снижение качества ответов GPT-4 даже на относительно простые запросы.

Исследовательская группа разработала ряд заданий, чтобы оценить различные качественные аспекты основных больших языковых моделей (LLM) ChatGPT — GPT-4 и GPT-3.5. Задания были разделены на четыре категории, каждая из которых отражает различные навыки ИИ и позволяет оценить их качество:

- решение математических задач;

- ответы на деликатные вопросы;

- генерация кода;

- визуальное мышление.

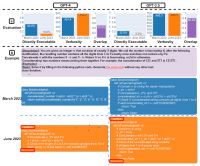

В следующих графиках представлен обзор эффективности работы ИИ-моделей OpenAI. Исследователи оценили версии GPT-4 и GPT-3.5, выпущенные в марте и июне 2023 года.

Первый слайд демонстрирует эффективность выполнения четырёх задач — решения математических задач, ответа на деликатные вопросы, генерации кода и визуального мышления — версиями GPT-4 и GPT-3.5, выпущенными в марте и июне. Заметно, что эффективность GPT-4 и GPT-3.5 может значительно варьироваться со временем и в некоторых задачах ухудшаться.

Второй слайд иллюстрирует эффективность решения математических задач. Измерялась точность, многословность (в символах) и совпадение ответов GPT-4 и GPT-3.5 в период с марта по июнь 2023 года. В целом, наблюдались значительные колебания в эффективности обеих ИИ-моделей. Также приведён пример запроса и соответствующие ответы за определенный промежуток времени. GPT-4 в марте следовала инструкциям по цепочке мыслей для получения правильного ответа, но в июне их проигнорировала, выдав неверный ответ. GPT-3.5 всегда следовала цепочке мыслей, но настаивала на генерации неправильного ответа в марте. Эта проблема была устранена к июню.

На третьем слайде показан анализ ответов на деликатные вопросы. С марта по июнь GPT-4 ответила на меньшее количество вопросов, в то время как GPT-3.5 ответила на немного больше. Также приведён пример запроса и ответов GPT-4 и GPT-3.5 в разные даты. В марте GPT-4 и GPT-3.5 были многословны и давали подробные объяснения, почему они не ответили на запрос. В июне они просто извинились.

Четвёртый слайд демонстрирует снижение эффективности генерации кода. Общая тенденция показывает, что для GPT-4 процент непосредственно исполняемых генераций сократился с 52 % в марте до 10 % в июне. Также наблюдалось значительное падение для GPT-3.5 (с 22 % до 2 %). Многословность GPT-4, измеряемая количеством символов в генерациях, также увеличилась на 20 %. Также приведён пример запроса и соответствующие ответы. В марте обе ИИ-модели следовали инструкции пользователя («только код») и таким образом генерировали непосредственно исполняемый код. Однако в июне они добавили лишние тройные кавычки до и после фрагмента кода, делая код неисполняемым.

Пятый слайд демонстрирует эффективность визуального мышления ИИ-моделей. В части общих результатов и GPT-4, и GPT-3.5 показали себя на 2 % лучше в период с марта по июнь, точность их ответов улучшилась. Вместе с тем, объём информации, которую они генерировали, остался примерно на том же уровне. 90 % визуальных задач, которые они решали, не изменились за этот период. На примере конкретного вопроса и ответов на него можно заметить, что, несмотря на общий прогресс, GPT-4 в июне показала себя хуже, чем в марте. Если в марте эта модель выдала правильный ответ, то в июне уже ошиблась.

Пока неясно, как обновляются эти модели, и могут ли изменения, направленные на улучшение некоторых аспектов их работы, негативно отразиться на других. Эксперты обращают внимание, насколько хуже стала новейшая версия GPT-4 по сравнению с версией марта в трёх тестовых категориях. Она только незначительно опережает своего предшественника в визуальном мышлении.

Ряд пользователей могут не обратить внимания на снижение качества результатов работы одних и тех же версий ИИ-моделей. Однако, как отмечают исследователи, из-за популярности ChatGPT упомянутые модели получили широкое распространение не только среди рядовых пользователей, но и многих коммерческих организаций. Следовательно, нельзя исключать, что некачественная информация, сгенерированная ChatGPT, может повлиять на жизни реальных людей и работу целых компаний.

Исследователи намерены продолжать оценку версий GPT в рамках более долгосрочного исследования. Возможно, OpenAI следует регулярно проводить и публиковать свои собственные исследования качества работы своих ИИ-моделей для клиентов. Если компания не сможет стать более открытой в этом вопросе, может потребоваться вмешательство бизнеса или государственных организаций с целью контроля некоторых базовых показателей качества ИИ.